- 廣告 -

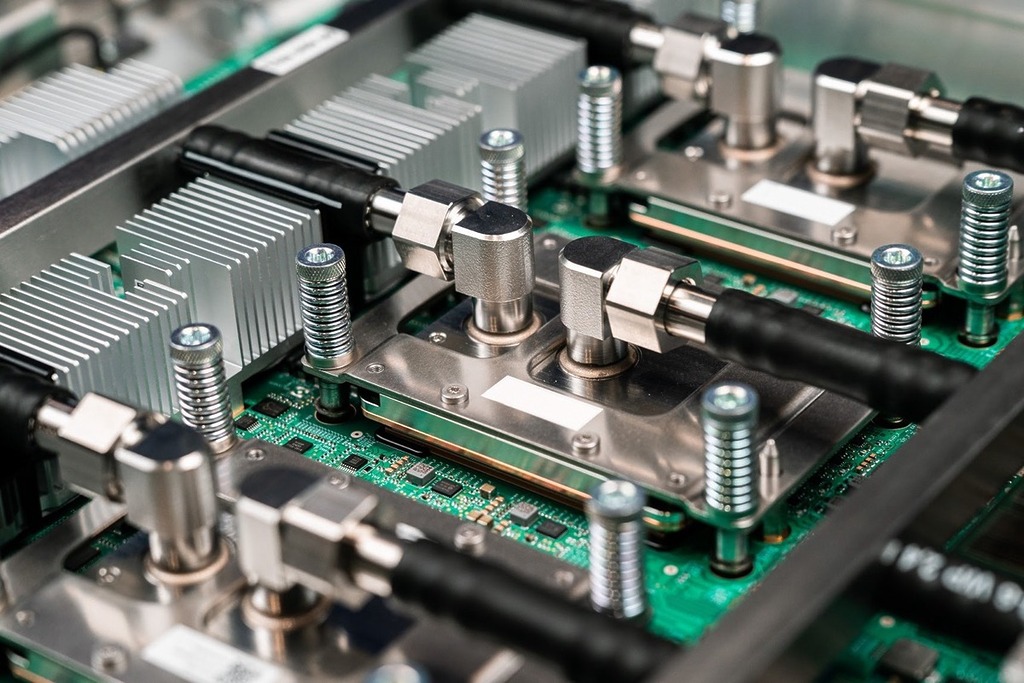

Google Cloud 終於正式推出 TPUv7 Ironwood。這晶片較前一代提升 4 倍效能,定位 Google Cloud 平台的 AI 推理 (Inference)TPU,用於高效能、低時延的 AI 服務,尤其是運行大型語言模型(LLM)的強勁需求。

早在今年的 Google Cloud Next 2025 大會已經發表 Ironwood TPU。根據 Google Cloud 公布的硬件設計特點:

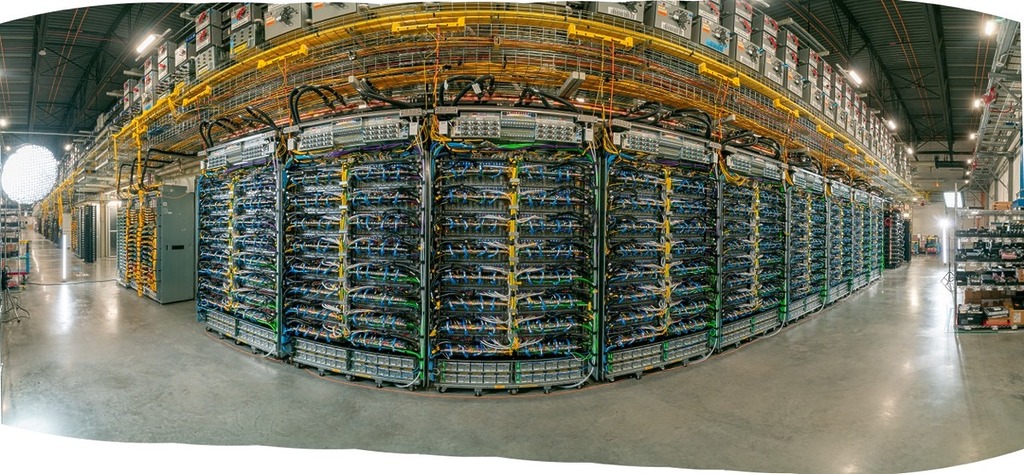

- Ironwood TPU 可在單一叢集連接最多 9,216 個晶片。

- 晶片之間互連,傳輸速度 9.6Tbps。

- 系統可共享 1.77PB 高頻寬記憶體(HBM)。

- 系統採用光學電路切換(OCS)技術,能動態調整網絡路由,可避開中斷,保障服務持續可用。

- 宣稱平台上目前效能與能源效益表現較為突出的客製化晶片之一。

Ironwood TPU 憑大容量記憶體、高速互連網絡,用於 AI 推理和推動 LLM 服務,如管理 LLM、專家混合模型(MoE)等複雜模型,提供大量運算資源,尤其處理深度思考的工作負載。

- 廣告 -

Ironwood TPU 亦配備加強的 SparseCore,用以支援對超大規模嵌入處理,有助提升在大型推薦系統和金融分析中常見的複雜排序工作。

Google Cloud 同時發佈 N4A 執行個體預覽版,採用自訂 Axion 的 Arm 晶片。宣稱為 Google 最具成本效益的 N 系列執行個體,較 x86 虛擬機器高 2 倍成本效益比,亦高 80% 效能耗能比。而上月正式可用的 C4A 執行個體,快將推出實體主機(bare metal)預覽,為 Google Cloud 平台首個 Arm 架構該類運算服務。

- 廣告 -